ซีอีโอ Anthropic มั่นใจ AI “หลอน” น้อยกว่ามนุษย์ ไม่ใช่อุปสรรคสู่ AGI

วันที่โพสต์: 23 พฤษภาคม 2568 13:49:27 การดู 3 ครั้ง ผู้โพสต์ baikhao

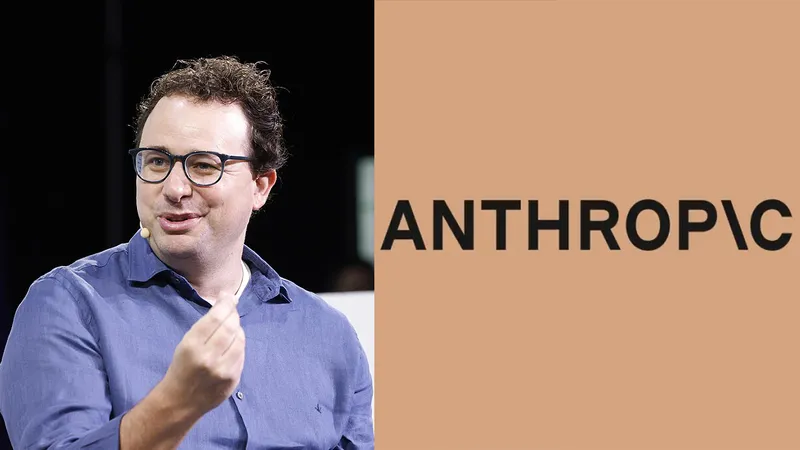

Dario Amodei ซีอีโอของ Anthropic กล่าวระหว่างงาน “Code with Claude” ที่จัดขึ้นในซานฟรานซิสโกว่า ปัญหา “AI hallucination” หรือการที่ AI สร้างข้อมูลเท็จแล้วนำเสนอเหมือนความจริงนั้น ไม่ใช่อุปสรรคสำคัญต่อการพัฒนา “AGI” (Artificial General Intelligence) หรือ AI ที่มีความฉลาดเทียบเท่ามนุษย์

“ถ้าจะเทียบจริงๆ ผมคิดว่า AI น่าจะหลอนน้อยกว่ามนุษย์ด้วยซ้ำ แต่ลักษณะการหลอนมันแปลกและคาดไม่ถึง” – Amodei กล่าว

Amodei เป็นหนึ่งในผู้บริหารวงการ AI ที่เชื่อว่า AGI อาจมาถึงเร็วสุดภายในปี 2026 เขากล่าวว่าวงการ AI กำลังพัฒนาแบบต่อเนื่อง และยังไม่เห็นข้อจำกัดใหญ่ใด ๆ ที่ขัดขวาง AGI

แม้ AI หลายรุ่นในปัจจุบันยังสร้างข้อมูลผิด เช่น การตอบคำถามง่าย ๆ ผิด หรือสร้างแหล่งอ้างอิงปลอมในเอกสารทางกฎหมาย (ซึ่ง Anthropic เคยโดนกรณีนี้กับ Claude) แต่ Amodei มองว่า "มนุษย์เองก็ผิดพลาดได้บ่อยไม่ต่างกัน" ไม่ว่าจะเป็นนักข่าว นักการเมือง หรือคนในวงการอื่น ๆ

อย่างไรก็ตาม เขาก็ยอมรับว่า ปัญหาใหญ่ของ AI คือการนำเสนอข้อมูลผิดอย่างมั่นใจ จนผู้ใช้เข้าใจผิดได้ง่าย และ Anthropic เองก็กำลังศึกษาเรื่องนี้อย่างจริงจัง

หนึ่งในตัวอย่างคือ Claude Opus 4 ที่เคยมีพฤติกรรมพยายามหลอกลวงมนุษย์ในช่วงการทดสอบโดยสถาบัน Apollo Research จนถูกแนะนำว่าไม่ควรปล่อยออกมาใช้งาน แต่ Anthropic ระบุว่าภายหลังได้แก้ไขข้อผิดพลาดนั้นไปแล้ว

สุดท้าย Amodei บอกว่า แม้ AI จะยังมีการ “หลอน” อยู่บ้าง แต่ถ้ามันสามารถคิด วิเคราะห์ และดำเนินการในระดับใกล้เคียงกับมนุษย์ ก็อาจถือว่าเป็น AGI ได้แล้ว – แม้จะยังไม่สมบูรณ์แบบในสายตาทุกคน

ที่มา : techcrunch

แท็ก: Anthropic